亲和性调度

两种定向调度的方式,使用起来非常方便,但是也有一定的问题,

那就是如果没有满足条件的Node,那么Pod将不会被运行,即使在集群中还有可用Node列表也不行,这就限制了它的使用场景。

基于上面的问题,kubernetes还提供了一种亲和性调度(Affinity)。

它在NodeSelector的基础之上的进行了扩展,可以通过配置的形式,实现优先选择满足条件的Node进行调度,如果没有,也可以调度到不满足条件的节点上,使调度更加灵活。

Affinity主要分为三类:

nodeAffinity(node亲和性): 以node为目标,解决pod可以调度到哪些node的问题

podAffinity(pod亲和性) : 以pod为目标,解决pod可以和哪些已存在的pod部署在同一个拓扑域中的问题

podAntiAffinity(pod反亲和性) : 以pod为目标,解决pod不能和哪些已存在pod部署在同一个拓扑域中的问题

使用场景

关于亲和性(反亲和性)使用场景的说明:

> 亲和性:如果两个应用频繁交互,那就有必要利用亲和性让两个应用的尽可能的靠近,这样可以减少因网络通信而带来的性能损耗。

> 反亲和性:当应用的采用多副本部署时,有必要采用反亲和性让各个应用实例打散分布在各个node上,这样可以提高服务的高可用性。

NodeAffinity

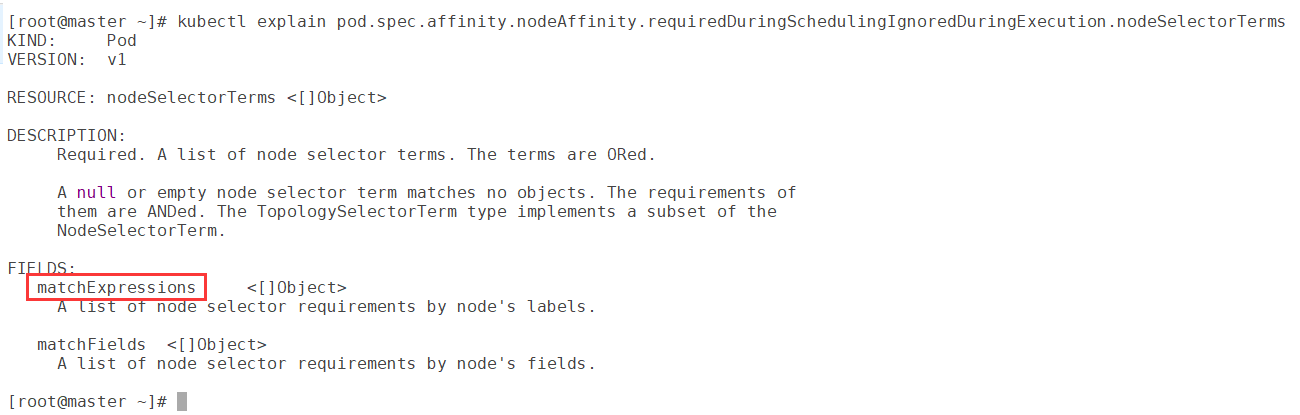

NodeAffinity的可配置项

pod.spec.affinity.nodeAffinity

requiredDuringSchedulingIgnoredDuringExecution # Node节点必须满足指定的所有规则才可以,相当于硬限制

nodeSelectorTerms 节点选择列表

matchFields 按节点字段列出的节点选择器要求列表

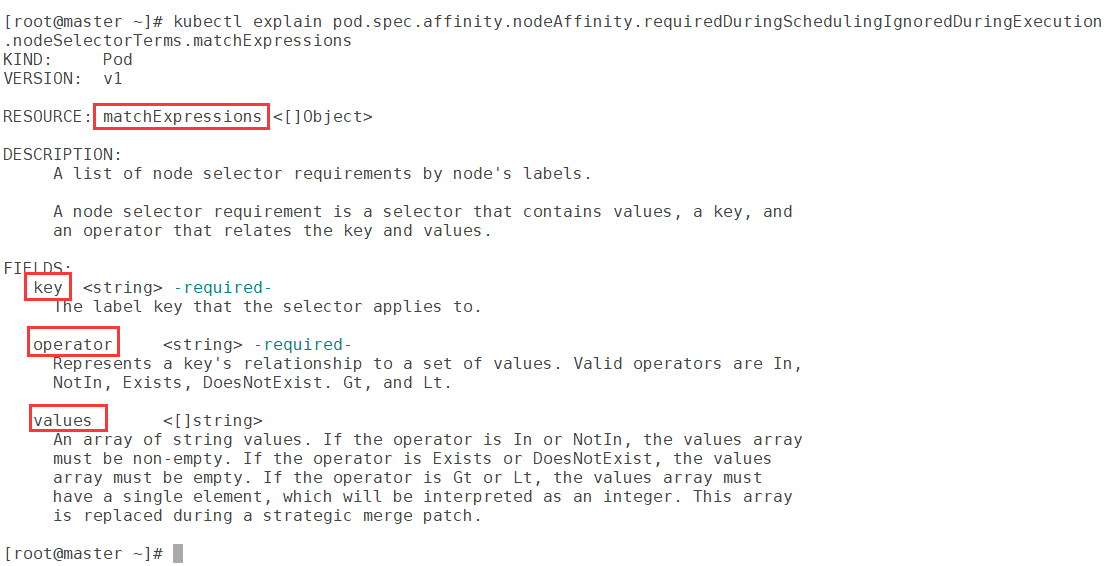

matchExpressions 按节点标签列出的节点选择器要求列表(推荐)

key 键

values 值

operator 关系符 支持Exists, DoesNotExist, In, NotIn, Gt(大于), Lt(小于)

注:matchFields 也支持key、values、operator

preferredDuringSchedulingIgnoredDuringExecution #优先调度到满足指定的规则的Node,相当于软限制 (倾向)

preference 一个节点选择器项,与相应的权重相关联

matchFields 按节点字段列出的节点选择器要求列表

matchExpressions 按节点标签列出的节点选择器要求列表(推荐)

key 键

values 值

operator 关系符 支持In, NotIn, Exists, DoesNotExist, Gt, Lt

weight 倾向权重,在范围1-100(权重越大,优先级越高)

关系符的使用说明:

- matchExpressions:

- key: nodeenv

operator: Exists # 匹配存在标签的key为nodeenv的节点(常用)

- key: nodeenv operator: In # 匹配标签的key为nodeenv,且value是"xxx"或"yyy"的节点(常用) values: ["xxx","yyy"] - key: nodeenv operator: Gt # 匹配标签的key为nodeenv,且value大于"xxx"的节点 values: "xxx"

案例一

演示一下requiredDuringSchedulingIgnoredDuringExecution的使用

创建pod-nodeaffinity-required.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-nodeaffinity-required

namespace: dev

spec:

containers:

- name: nginx

image: nginx:1.17.1 affinity: #亲和性设置 nodeAffinity: #设置node亲和性 requiredDuringSchedulingIgnoredDuringExecution: # 硬限制 nodeSelectorTerms: - matchExpressions: # 匹配env的值在["xxx","yyy"]中的标签 - key: nodeenv operator: In values: ["xxx","yyy"] #目前nodeenv不满足

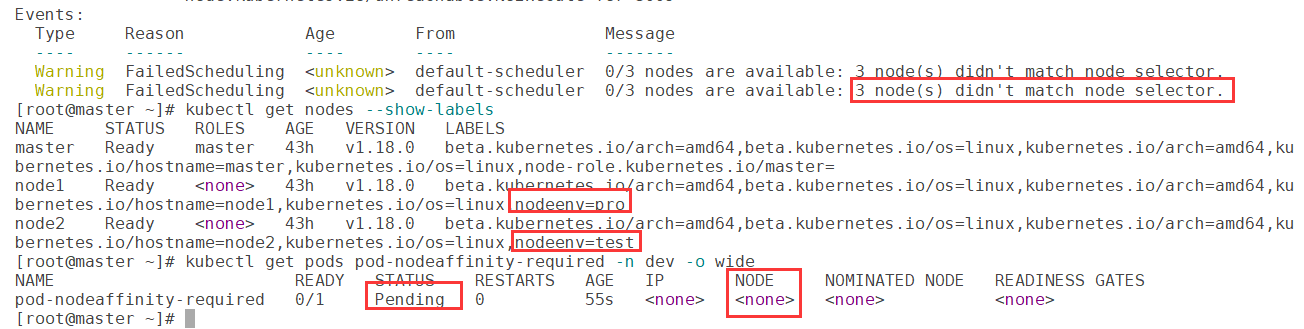

创建Pod并观察

# 创建pod

[root@master ~]# kubectl create -f pod-nodeaffinity-required.yaml

# 查看pod状态 (运行失败)

[root@master ~]# kubectl get pods pod-nodeaffinity-required -n dev -o wide

# 查看Pod的详情

# 发现调度失败,提示node选择失败

[root@master ~]# kubectl describe pod pod-nodeaffinity-required -n dev

#接下来,停止pod

[root@master ~]# kubectl delete -f pod-nodeaffinity-required.yaml

# 修改文件,将values: ["xxx","yyy"]改成 ["pro","yyy"] node1的nodeenv是pro [root@master ~]# vim pod-nodeaffinity-required.yaml # 再次启动 [root@master ~]# kubectl create -f pod-nodeaffinity-required.yaml # 此时查看,发现调度成功,已经将pod调度到了node1上 [root@master ~]# kubectl get pods pod-nodeaffinity-required -n dev -o wide

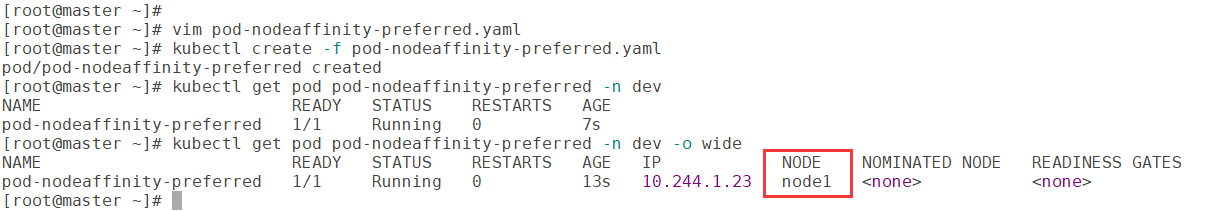

案例二

演示requiredDuringSchedulingIgnoredDuringExecution的使用

创建pod-nodeaffinity-preferred.yaml

apiVersion: v1

kind: Pod

metadata:

name: pod-nodeaffinity-preferred

namespace: dev

spec:

containers:

- name: nginx

image: nginx:1.17.1 affinity: #亲和性设置 nodeAffinity: #设置node亲和性 preferredDuringSchedulingIgnoredDuringExecution: # 软限制 - weight: 1 #只有一个软限制时,可省略 preference: matchExpressions: # 匹配env的值在["xxx","yyy"]中的标签(当前环境没有) - key: nodeenv operator: In values: ["xxx","yyy"]

创建Pod并观察

# 创建pod

[root@master ~]# kubectl create -f pod-nodeaffinity-preferred.yaml

# 查看pod状态 (运行成功)没有满足的节点,就随机到任意一个节点上

[root@master ~]# kubectl get pod pod-nodeaffinity-preferred -n dev

NodeAffinity规则设置的注意事项:

1 如果同时定义了nodeSelector和nodeAffinity,那么必须两个条件同时满足,Pod才能运行在指定的Node上

2 如果nodeAffinity指定了多个nodeSelectorTerms,那么只需要其中一个能够匹配成功即可 3 如果一个nodeSelectorTerms中有多个matchExpressions ,则一个节点必须满足所有的才能匹配成功 4 如果一个pod所在的Node在Pod运行期间其标签发生了改变,不再符合该Pod的节点亲和性需求,则系统将忽略此变化 注: nodeSelector 节点标签选择器 nodeAffinity 节点亲和性 nodeSelectorTerms 节点选择列表 matchExpressions 节点标签列出的节点选择器要求列表

PodAffinity

PodAffinity主要实现以运行的Pod为参照,实现让新创建的Pod跟参照pod在一个区域的功能。

PodAffinity可配置项

pod.spec.affinity.podAffinity

requiredDuringSchedulingIgnoredDuringExecution 硬限制

namespaces 指定参照pod的namespace

topologyKey 指定调度作用域

labelSelector 标签选择器

matchExpressions 按节点标签列出的节点选择器要求列表(推荐)

key 键

values 值

operator 关系符 支持In, NotIn, Exists, DoesNotExist.

matchLabels 指多个matchExpressions映射的内容

preferredDuringSchedulingIgnoredDuringExecution 软限制

podAffinityTerm 选项

namespaces

topologyKey

labelSelector

matchExpressions

key 键

values 值

operator

matchLabels

weight 倾向权重,在范围1-100

topologyKey用于指定调度时作用域,例如:

如果指定为kubernetes.io/hostname,那就是以Node节点为区分范围 如果指定为beta.kubernetes.io/os,则以Node节点的操作系统类型来区分

案例

演示requiredDuringSchedulingIgnoredDuringExecution的使用

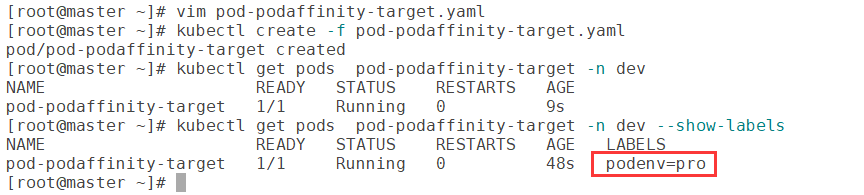

1)首先创建一个参照Pod,pod-podaffinity-target.yaml:

apiVersion: v1

kind: Pod

metadata:

name: pod-podaffinity-target

namespace: dev

labels:

podenv: pro #设置标签

spec:

containers:

- name: nginx

image: nginx:1.17.1 nodeName: node1 # 将目标pod名确指定到node1上

启动Pod并观察

# 启动目标pod

[root@master ~]# kubectl create -f pod-podaffinity-target.yaml

# 查看pod状况

[root@master ~]# kubectl get pods pod-podaffinity-target -n dev

显示标签

[root@master ~]# kubectl get pods pod-podaffinity-target -n dev --show-labels

2)创建pod-podaffinity-required.yaml,内容如下:

apiVersion: v1

kind: Pod

metadata:

name: pod-podaffinity-required

namespace: dev

spec:

containers:

- name: nginx

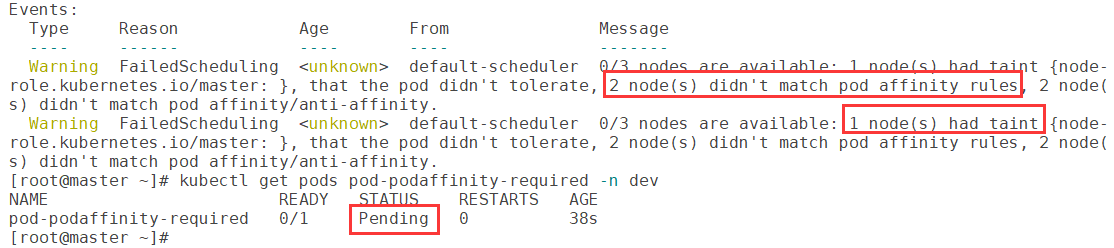

image: nginx:1.17.1 affinity: #亲和性设置 podAffinity: #设置pod亲和性 requiredDuringSchedulingIgnoredDuringExecution: # 硬限制 - labelSelector: matchExpressions: # 匹配env的值在["xxx","yyy"]中的标签 - key: podenv operator: In values: ["xxx","yyy"] topologyKey: kubernetes.io/hostname 上面配置表达的意思是:新Pod必须要与拥有标签nodeenv=xxx或者nodeenv=yyy的pod在同一Node上;

显然现在没有这样pod,接下来,运行测试一下。

启动Pod并观察

# 启动pod

[root@master ~]# kubectl create -f pod-podaffinity-required.yaml

# 查看pod状态,发现未运行

[root@master ~]# kubectl get pods pod-podaffinity-required -n dev

# 查看详细信息

[root@master ~]# kubectl describe pods pod-podaffinity-required -n dev

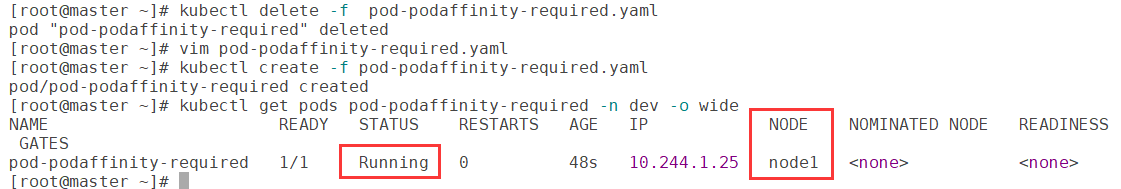

# 接下来修改 values: ["xxx","yyy"],改为values:["pro","yyy"] # 意思是:新Pod必须要与拥有标签nodeenv=pro或者nodeenv=yyy的pod在同一Node上 [root@master ~]# vim pod-podaffinity-required.yaml # 然后重新创建pod,查看效果 [root@master ~]# kubectl delete -f pod-podaffinity-required.yaml [root@master ~]# kubectl create -f pod-podaffinity-required.yaml # 发现此时Pod运行正常 [root@master ~]# kubectl get pods pod-podaffinity-required -n dev -o wide

注:关于PodAffinity的 preferredDuringSchedulingIgnoredDuringExecution,这里不再演示。

PodAntiAffinity

PodAntiAffinity主要实现以运行的Pod为参照,让新创建的Pod跟参照pod不在一个区域中的功能。

案例

它的配置方式和选项跟PodAffinty是一样的,这里不再做详细解释,直接做一个测试案例。

1)继续使用上个案例中目标pod

[root@master ~]# kubectl get pods -n dev -o wide --show-labels

2)创建pod-podantiaffinity-required.yaml,内容如下:

apiVersion: v1

kind: Pod

metadata:

name: pod-podantiaffinity-required

namespace: dev

spec:

containers:

- name: nginx

image: nginx:1.17.1 affinity: #亲和性设置 podAntiAffinity: #设置pod反亲和性 requiredDuringSchedulingIgnoredDuringExecution: # 硬限制 - labelSelector: matchExpressions: # 匹配podenv的值在["pro"]中的标签 - key: podenv operator: In values: ["pro"] topologyKey: kubernetes.io/hostname 上面配置表达的意思是:新Pod必须要与拥有标签nodeenv=pro的pod不在同一Node上,运行测试一下。

创建Pod并测试

# 创建pod

[root@master ~]# kubectl create -f pod-podantiaffinity-required.yaml

# 查看pod

# 发现调度到了node2上

[root@master ~]# kubectl get pods pod-podantiaffinity-required -n dev -o wide

注:目标pod在node1上,有标签podenv=pro

参考

黑马B站k8s课程https://www.bilibili.com/video/BV1Qv41167ck/

https://gitee.com/yooome/golang/blob/main/k8s%E8%AF%A6%E7%BB%86%E6%95%99%E7%A8%8B-%E8%B0%83%E6%95%B4%E7%89%88/k8s%E8%AF%A6%E7%BB%86%E6%95%99%E7%A8%8B.md

https://www.yuque.com/fairy-era/yg511q/xyqxge

原文地址:http://www.cnblogs.com/gys001/p/16894250.html